- Dec 12, 2025

Quand les nounours font du "neurofeedback"

- Brendan Parsons, Ph.D., BCN

- Neurosciences, Neurofeedback

Recevez le NeuroBLOG dans votre inbox

Si vous vous êtes déjà demandé si un système de neurofeedback pouvait « améliorer » le cerveau d’un ours en peluche, une étude exploratoire de 2011 menée par Rubén Pérez-Elvira et María Gracia Carpena-Niño a précisément fait cela… et pas entièrement pour plaisanter. En utilisant le système NeurOptimal de Zengar, les auteurs ont fixé des électrodes sur trois animaux en peluche et les ont traités comme s’il s’agissait de vrais participants humains, en leur attribuant des âges allant de l’adolescence au grand âge. Leur objectif était simple, mais incisif : si un système de neurofeedback automatisé montre des effets d’entrainement robustes chez des peluches, avec quel degré de confiance pouvons-nous interpréter des changements similaires chez de vrais patients ?

Cet article vient des archives, mais son message parait étonnamment actuel – et sans doute encore plus pertinent aujourd’hui, alors que les outils d’« optimisation cérébrale sans effort » envahissent le marché. Soyons clairs dès le départ : ils empruntent peut-être le nom, mais ces trucs ne sont PAS du neurofeedback.

Le neurofeedback, en termes généraux, est une forme de biofeedback où l’on mesure l’activité cérébrale – généralement à l’aide de l’ÉEG – et où l’on renvoie cette information en temps réel à la personne afin qu’elle apprenne à la réguler. Le biofeedback, plus largement, utilise des signaux comme la fréquence cardiaque, la tension musculaire ou la conductance cutanée pour soutenir l’autorégulation. Dans ses meilleures versions, le neurofeedback est un outil d’apprentissage sophistiqué qui aide le cerveau à ajuster des schémas liés à l’attention, à l’humeur, au sommeil ou à l’activation.

Mais que se passe-t-il lorsque le système d’apprentissage est une boite noire hermétique, et que l’on ne sait pas très bien ce que représente le paramètre de retour d’information – ni même s’il reflète véritablement le cerveau ? NeurOptimal, qui est commercialisé comme une forme de neurofeedback, n’utilise pas de cartographie ÉEGq (quantitative EEG, cartographie ÉEG quantitative), ne permet pas au clinicien de cibler des bandes de fréquences ou des régions spécifiques, et ne fournit pas de paramètres d’entrainement transparents. À la place, il s’appuie sur un algorithme propriétaire (un indice de « divergence ») qui est censé refléter le degré de « perturbation » du fonctionnement électrique cérébral, avec des valeurs tendant vers zéro à mesure que le système « optimise » l’activité.

Les auteurs de cette étude ont décidé de mettre cette hypothèse à l’épreuve de la manière la plus délicieusement absurde possible : en traitant des peluches comme des clients et en observant si elles « s’améliorent » avec l’entrainement.

Méthodes

Le plan de cette étude ressemble à un croisement entre une section Méthodes classique et un sketch de comédie neuroscientifique, mais sous la satire se cache un raisonnement très sérieux. Trois animaux en peluche ont été sélectionnés parmi six, choisis pour la similarité de leur composition matérielle. Ces peluches ont ensuite été réparties en trois catégories d’âge, formant une matrice 3×3 de « participants » :

Groupe A : « adolescents » (10, 14, 16 ans)

Groupe B : « jeunes adultes » (40, 40, 44 ans)

Groupe C : « personnes âgées » (74, 80, 82 ans)

Bien entendu, les jouets eux-mêmes ne vieillissaient pas entre les séances ; les chercheurs utilisaient simplement l’interface de NeurOptimal pour attribuer différents âges et identifiants aux mêmes animaux en peluche, créant ainsi neuf « participants » à partir de trois morceaux de mousse et de tissu.

Chaque « participant » a reçu des séances avec NeurOptimal selon les recommandations du fabricant : un enregistrement de base pré-entrainement, une phase d’entrainement en neurofeedback, puis un enregistrement de base post-entrainement. Les électrodes étaient fixées avec de la pâte conductrice Ten20 et, pour garantir un placement constant entre les séances, les auteurs ont laissé sur la « fourrure » des marques visibles de pâte séchée comme repère. Ce détail, décrit dans la discussion, est à la fois attendrissant et méthodologiquement solide : la même zone non cérébrale de chaque peluche recevait les électrodes à chaque fois, réduisant la variabilité due à la position.

Pour limiter encore davantage les biais, chaque animal en peluche a effectué trois séances consécutives – une pour chaque condition d’âge – sans retirer les électrodes. En pratique, cela signifie que le « Participant 1A » (ado), le « Participant 1B » (adulte jeune) et le « Participant 1C » (âgé) étaient en fait le même jouet, mesuré trois fois de suite, seule la donnée d’âge changée dans le logiciel. Les données brutes du système NeurOptimal étaient exportées sous forme d’indice de divergence propriétaire pour les baselines pré- et post-entrainement. Des valeurs de divergence plus élevées étaient interprétées par le logiciel comme une activité électrique plus dysrégulée ; des valeurs plus proches de zéro étaient supposées refléter un fonctionnement plus « optimal ».

Les chercheurs ont ensuite saisi ces scores de divergence dans Excel pour une première analyse et prévu des analyses supplémentaires sous SPSS. Ils ont calculé les valeurs moyennes pré- et post-entrainement pour chacun des neuf « participants », ainsi que des moyennes par groupe pour les adolescents, les jeunes adultes et les personnes âgées. Ils ont enfin examiné les corrélations entre l’âge et la divergence, et entre le nombre de séances et l’évolution de la divergence.

En d’autres termes, ils ont traité cette expérience comme une véritable étude de résultats en neurofeedback… sauf que les « cerveaux » étaient remplis de mousse, pas de neurones.

Résultats

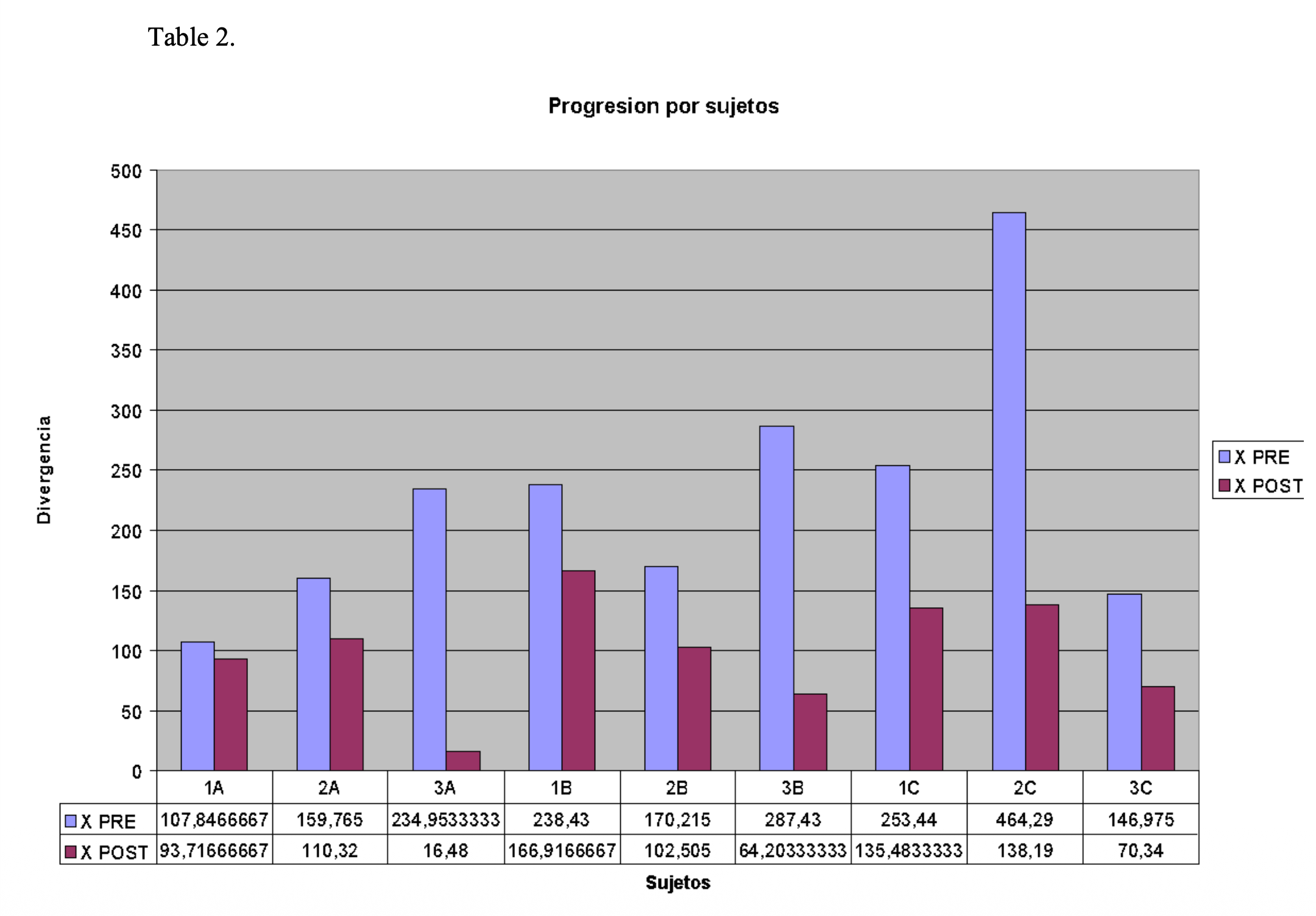

Même si les sujets étaient inanimés, les données se comportaient comme si de véritables changements physiologiques se produisaient. Pour l’ensemble des neuf « participants », l’indice de divergence a diminué entre les baselines pré- et post-entrainement. L’histogramme de la page 3 de l’article (« Progression par sujets ») montre un motif très net : pour chaque peluche, dans chaque condition d’âge, les barres de pré-entrainement (bleu) sont plus hautes que celles de post-entrainement (violet), ce qui suggère que le système percevait chaque jouet comme devenant plus « régulé » au fil des séances.

Lorsque les auteurs ont moyenné les scores par groupe, le même schéma persistait. Le Tableau 1 et le graphique de la page 4 montrent que les moyennes de groupe diminuaient fortement du pré au post pour les adolescents (Groupe A), les jeunes adultes (Groupe B) et les personnes âgées (Groupe C). La divergence moyenne totale, toutes séances confondues, passait d’environ 217,6 en pré-entrainement à 102,8 en post-entrainement – soit presque une division par deux de la « dysrégulation » dans la population de peluches.

Les corrélations ajoutent une couche supplémentaire d’humour noir. L’âge était positivement corrélé à la divergence de base initiale (ρ ≈ 0,61), ce qui signifie que les peluches « plus âgées » commençaient avec des scores de divergence plus élevés, tandis que les plus jeunes paraissaient plus « saines électriquement ». Lorsque les auteurs ont agrégé les données par moyennes de groupe, cette relation devenait extrêmement forte (ρ ≈ 0,99 en baseline pré), suggérant que l’indice de divergence suivait de près le champ « âge » saisi dans le logiciel – même si l’objet physique, lui, ne changeait jamais.

Après l’entrainement, l’âge n’était plus que faiblement corrélé à la divergence post-baseline au niveau individuel (ρ ≈ 0,14), mais restait fortement corrélé au niveau des moyennes de groupe (ρ ≈ 0,87). De même, le nombre de séances montrait une corrélation négative avec la divergence post-entrainement (ρ ≈ −0,47 pour les données individuelles et ≈ −0,997 pour les moyennes de groupe) : plus il y avait de séances, meilleurs étaient les « résultats », même chez des jouets sans aucune activité cérébrale.

Fait amusant, le texte de la discussion suggère que les adolescents s’améliorent le plus et les personnes âgées le moins, alors que le tableau numérique semble montrer la plus grande différence pré-post dans le groupe « âgé ». Cette légère incohérence interne souligne bien le message principal des auteurs : lorsque les participants sont en peluche, toute tentative d’interprétation fine devient rapidement un peu absurde.

En fin de compte, les auteurs concluent que, puisque les peluches n’ont pas d’activité électrique cérébrale – et que le bruit électrique ambiant devrait rester relativement constant – il est difficile de concilier des effets systématiques d’âge et d’amélioration pré-post avec une lecture directe de l’indice de divergence comme reflet d’une véritable autorégulation cérébrale.

Discussion

Sous l’humour consistant à connecter des ours en peluche à un système de neurofeedback se cache une question méthodologique cruciale : comment savoir si un indicateur de neurofeedback reflète réellement l’activité cérébrale ou simplement le comportement du logiciel ? Cette étude utilise la satire comme test de résistance. En appliquant NeurOptimal à de la matière inerte et en observant malgré tout des améliorations systématiques et des effets d’âge, les auteurs soulignent la nécessité d’une validation rigoureuse des systèmes en boite noire.

L’un des éléments les plus frappants est à quel point les données ont l’air « vraies ». Des améliorations pré-post, des différences liées à l’âge et des relations dose–réponse (plus de séances, meilleurs résultats) sont exactement le genre de motifs que les cliniciens adorent voir chez leurs clients humains. Si les mêmes motifs peuvent être produits chez des peluches simplement en changeant les paramètres d’âge dans le logiciel et en répétant les séances, nous sommes obligés de nous demander : quelle part de ce que nous voyons sur les tableaux de bord cliniques vient réellement du cerveau, et quelle part vient de l’algorithme ?

Pour les personnes qui envisagent le neurofeedback, cela ne signifie pas que tous les systèmes sont factices ou que leurs améliorations sont imaginaires. Ce que cette étude tourne en dérision, ce n’est pas le neurofeedback dans son ensemble, mais spécifiquement les produits en boite noire comme NeurOptimal, qui empruntent le langage du neurofeedback sans offrir les éléments fondamentaux qui en font une intervention scientifique : des cibles basées sur une évaluation ou un ÉEGq, des bandes de fréquences et des sites ÉEG clairement définis, et un traitement du signal transparent. Les corps et les cerveaux sont extrêmement entrainables ; des années de recherche utilisant des protocoles basés sur l’ÉEG, du neurofeedback en IRMf et des formes classiques de biofeedback (comme l’entrainement en cohérence cardiaque) montrent des changements significatifs au niveau des symptômes, de la cognition et de la physiologie. Ce que cette expérience sur des ours en peluche met en lumière, c’est le risque de faire une confiance excessive à tout dispositif qui résume un traitement interne complexe en un score unique et rassurant, comme la « divergence », surtout lorsque ce score est opaque et propriétaire.

Pour les cliniciens qui orientent vers des services de neurofeedback, cette étude est un rappel doux mais ferme : il est utile de poser quelques questions difficiles avant d’adresser des patients. Le système donne-t-il accès au signal ÉEG brut ou à d’autres données physiologiques, ou seulement à un indice en boite noire ? Existe-t-il des études avec comité de lecture montrant que ses indicateurs suivent de véritables changements cérébraux, idéalement mesurés avec du matériel indépendant ? L’amélioration est-elle définie uniquement par les chiffres produits par le dispositif, ou par un ensemble convergent d’indices cliniques : symptômes, comportement, ÉEGq, tests cognitifs, questionnaires standardisés ?

Pour les praticiens du neurofeedback, le message est peut-être le plus cinglant – surtout pour celles et ceux qui se demandent si des systèmes « plug-and-play » comme NeurOptimal appartiennent vraiment à la même catégorie que le neurofeedback ÉEG guidé par ÉEGq et fondé sur des protocoles précis. Beaucoup d’entre nous s’appuient sur des caractéristiques ÉEG observables et interprétables : excès de thêta fronto-centrale associé à l’inattention, faible rythme sensorimoteur (SMR) à C3/C4 dans l’hyperactivité, asymétries d’alpha frontal dans les troubles de l’humeur. Les protocoles classiques de neurofeedback ÉEG – en particulier lorsqu’ils sont éclairés par un ÉEGq – établissent des ponts explicites et testables entre ces motifs, les cibles d’entrainement et l’expérience du client. Lorsqu’un système obscurcit ce lien, en remplaçant des fréquences et des sites concrets par une variable globale unique qui semble toujours diminuer au fil du temps, nous perdons la capacité de vérifier de manière critique si le feedback fait réellement ce qu’il prétend.

Plus largement, ce travail fait écho aux résultats d’études de neurofeedback avec conditions sham : une partie des bénéfices cliniques provient probablement de facteurs non spécifiques, tels que l’attention du thérapeute, le temps de relaxation, les attentes et le cadre thérapeutique lui-même. L’étude sur les ours en peluche enlève astucieusement toutes ces variables humaines et montre que le dispositif seul peut générer un récit d’amélioration séduisant. Cela ne remet pas en cause les changements de neuroplasticité observés dans des essais rigoureux de protocoles comme l’entrainement du SMR pour le TDAH ou l’augmentation de l’alpha pour l’anxiété ; en revanche, cela rappelle que les dispositifs qui ne peuvent pas être validés de manière indépendante doivent être examinés avec une vigilance accrue.

Une lecture interprétative de cet article consiste à y voir une critique de ce que l’on pourrait appeler le « neuro-théâtre » : la tendance à envelopper des soins de soutien classiques dans une esthétique high-tech et un discours « neuro » sans apporter le niveau de preuve correspondant. NeurOptimal, tel qu’il apparait ici, en est un parfait exemple : un branding sophistiqué, des promesses très affirmées et un indicateur global bien propre, mais aucun moyen de vérifier que le feedback est réellement contingent à une activité cérébrale significative. Lorsque les clients (ou les praticiens) sont éblouis par des tableaux de bord colorés et des indices au nom impressionnant, il devient plus facile de confondre l’apparence de la précision avec une compréhension réelle des mécanismes. Des dispositifs satiriques comme celui-ci jouent un rôle important pour nous ramener sur terre : si votre système de « neurofeedback » peut réhabiliter avec succès un octogénaire en peluche, il est peut-être temps de reconsidérer ce que vos métriques signifient vraiment.

La perspective de Brendan

Je l’avoue : l’image mentale de quelqu’un qui marque soigneusement des emplacements d’électrodes sur la tête d’un ours en peluche avec de la pâte Ten20 va me rester en tête pendant un moment. C’est drôle, oui – mais cela révèle aussi quelque chose d’essentiel sur la façon dont le neurofeedback peut parfois déraper. Quand on traite le dispositif comme un optimiseur cérébral magique, on risque d’oublier les fondamentaux : la qualité du signal, des cibles claires, la plausibilité physiologique, et le bon vieux sens critique.

Dans la pratique clinique quotidienne, je m’ancre toujours sur la combinaison de trois éléments : une histoire cohérente des difficultés de la personne, des motifs ÉEG observables (souvent à partir d’un ÉEGq ou au minimum de baselines structurées), et la manière dont la personne s’adapte aux protocoles que nous choisissons en réponse. Par exemple, chez un client présentant de l’impulsivité et une agitation motrice, je peux travailler le SMR (12–15 Hz) à des sites comme C4 ou C3, en inhibant un excès de thêta (4–7 Hz) et de haut bêta (22–30 Hz). Chez quelqu’un avec une rumination anxieuse et des difficultés à se poser, je peux privilégier l’augmentation de l’alpha postérieur (environ 9–12 Hz) à POz, tout en inhibant doucement le bêta rapide. Ces choix ne sont pas magiques ; ce sont des hypothèses, fondées sur des décennies de recherche ÉEG et constamment réajustées en observant comment la personne réagit.

Maintenant, imaginez remplacer tout ce processus par un seul nombre, étiqueté « divergence » ou « stabilité », qui s’améliore régulièrement à chaque séance, quel que soit ce qui se trouve réellement sous les électrodes – et, comme le montre cette étude, même lorsqu’il n’y a pas de cerveau du tout. C’est essentiellement ce que cette étude sur les ours en peluche pointe du doigt avec NeurOptimal. Si des animaux en peluche montrent les mêmes courbes descendantes élégantes de divergence que nos clients humains, nous devrions être très prudents avant d’utiliser ce nombre comme preuve de changement cérébral.

C’est là que l’individualisation des protocoles devient cruciale. Deux clients avec le même diagnostic – disons un TDAH – peuvent avoir des profils ÉEG très différents. L’un peut présenter un thêta frontal élevée et un bêta faible ; l’autre peut avoir un ratio thêta/bêta relativement normal, mais une réactivité émotionnelle marquée avec des salves de haut bêta en région frontale droite. Dans le premier cas, un protocole classique de diminution du thêta et d’augmentation du bêta à Fz ou Cz peut être approprié ; dans le second, je pourrais privilégier le SMR à C4 et l’inhibition du haut bêta à F4, en ajoutant des approches complémentaires, comme l’entrainement en cohérence cardiaque (HRV) et une psychothérapie centrée sur les émotions. Un indicateur global « taille unique » ne peut pas raconter ces histoires-là.

La satire met aussi en relief à quel point il est important de regarder le signal brut. Avec tout système ÉEG que j’accepte d’utiliser en clinique, je veux voir la forme d’onde réelle, vérifier les impédances et observer comment les artéfacts – clignements des yeux, tension musculaire, serrage de mâchoire – apparaissent dans l’enregistrement. Si tout ce que je vois est un indicateur de tableau de bord qui glisse tranquillement du rouge au vert, je vole à l’aveugle. À l’inverse, les plateformes de neurofeedback bien conçues vous permettent de voir les données que vous entrainez, de confirmer qu’elles ressemblent à un ÉEG humain plausible, et de relier les changements dans ce signal à l’expérience subjective de la personne. (Petite précision : sur chacun de mes écrans d’entrainement, on voit le signal ÉEG brut, et je ne travaillerai jamais avec un système qui ne le permet pas.)

Une autre leçon des ours en peluche concerne la méthodologie de recherche. Les bons essais de neurofeedback incluent de plus en plus souvent des conditions sham ou de feedback non contingent, où le retour n’est plus lié à l’activité cérébrale de la personne. Lorsque des améliorations apparaissent à la fois dans les groupes « réel » et sham, nous apprenons que les facteurs non spécifiques font une partie du travail. Lorsque seul le groupe en feedback réel montre des changements durables, à la fois physiologiques et comportementaux, nous gagnons en confiance dans le fait que nous mobilisons un véritable apprentissage cérébral. Faire une condition sham sur des peluches est une manière délicieusement irrévérencieuse de poser la question : « Quelle part de cet effet nécessite réellement un cerveau ? »

En termes de méthodes complémentaires, je suis un grand adepte de la combinaison entre un neurofeedback ÉEG authentique – ancré dans un ÉEGq ou au moins dans une évaluation structurée, avec des cibles de bandes et de sites clairement définies – et d’autres outils psychophysiologiques. Le biofeedback HRV peut soutenir la régulation autonome et l’interoception, tandis que le biofeedback EMG aide les clients à reconnaitre et relâcher des tensions musculaires chroniques. Dans bien des cas, ces outils sont plus transparents que certains systèmes de neurofeedback opaques : on sent sa respiration ralentir, on voit les oscillations de la fréquence cardiaque se lisser, on expérimente directement le changement d’état. Quand on ajoute par-dessus un entrainement en neurofeedback fondé sur des protocoles clairs – par exemple, augmentation de l’alpha à POz chez un client avec hypervigilance liée à un traumatisme, ou diminution du bêta à F3/Fz chez quelqu’un avec des pensées qui tournent en boucle – on travaille avec un modèle stratifié et intelligible, plutôt qu’avec un indice mystique unique.

Qu’en est-il de l’application des leçons de cet article à d’autres populations ? Une conclusion évidente est que, chaque fois que nous travaillons avec des clients vulnérables – enfants, personnes avec troubles neurodéveloppementaux, personnes avec maladies neurologiques progressives –, nous leur devons une rigueur supplémentaire. Cela implique d’utiliser des systèmes et des protocoles avec des mécanismes traçables : si nous affirmons que l’entrainement du SMR à Cz peut stabiliser l’endormissement et réduire les réveils nocturnes, nous devrions pouvoir montrer des changements de puissance SMR, des journaux de sommeil, et idéalement des mesures objectives du sommeil. Une métrique qui s’améliore de la même manière chez des ours en peluche et des adolescents ne répond tout simplement pas à ce critère.

Pourtant, je ne vois pas cette satire comme anti-neurofeedback. Au contraire, elle est profondément pro-neurofeedback quand il est bien fait, et très critique envers des produits comme NeurOptimal qui, à mes yeux, se rapprochent davantage d’une expérience de relaxation/multimédia emballée que d’un neurofeedback au sens scientifique. Elle nous éloigne de la confiance aveugle dans la technologie et nous ramène aux fondamentaux : l’apprentissage, la physiologie et la relation thérapeutique. Elle nous rappelle que le but n’est pas de rendre un chiffre plus joli sur un écran, mais d’aider de vrais systèmes nerveux à trouver des modes de fonctionnement plus flexibles et plus résilients.

Alors, la prochaine fois que vous verrez un dispositif qui promet « d’optimiser votre cerveau sans effort », avec une évaluation minimale et aucune explication claire de ce qui est réellement entrainé, vous pourrez discrètement vous demander : est-ce que cela fonctionnerait aussi sur un ours en peluche ? Si la réponse honnête est « probablement », ce système a sans doute plus sa place au rayon jouets qu’en clinique.

Conclusion

L’étude NeurOptimal sur des animaux en peluche est drôle en surface, mais ses implications sont très sérieuses pour la manière dont nous parlons de ce qui est – et de ce qui n’est pas – du vrai neurofeedback. En montrant qu’un système de « neurofeedback » automatisé peut produire des motifs convaincants d’amélioration et des effets liés à l’âge chez de la matière inerte, les auteurs nous obligent à questionner la manière dont nous validons les métriques propriétaires et interprétons des tableaux de bord séduisants. Ces résultats ne remettent pas en cause le solide corpus de données soutenant le neurofeedback ÉEG guidé par ÉEGq, ainsi que d’autres formes de biofeedback, comme outils d’autorégulation et de changement symptomatique ; ils soulignent toutefois la différence entre des protocoles transparents, fondés sur des mécanismes identifiables, et des promesses d’« optimisation » opaques issues de boîtes noires comme NeurOptimal.

Pour les clients, c’est une invitation à poser de meilleures questions. Pour les cliniciens et les chercheurs, c’est un encouragement à privilégier des systèmes qui nous permettent de voir et de comprendre les signaux que nous entrainons – et à inclure de vrais contrôles, y compris des conditions sham, lorsque cela est approprié. Pour le domaine dans son ensemble enfin, c’est un rappel que notre travail concerne avant tout des systèmes nerveux vivants et dynamiques, pas de simples sorties logicielles.

Lorsque le neurofeedback est ancré dans une bonne science, une évaluation réfléchie et un lien humain authentique, il n’a pas besoin d’impressionner des ours en peluche pour changer des vies.

Références

Pérez-Elvira, R., & Carpena-Niño, M. G. (2011). Scoping study on OPERATION NeurOptimal of Zengar [Unpublished manuscript]. Program Mental Rehabilitation, Hospital Care Center LAGUNA. Full text available here.

Texte intégral disponible ici.

Vous voulez recevoir nos Newsletters?

Recevez une fois par mois une synthèse de toutes nos activités